一种基于对抗虚拟离群值生成的鲁棒分布外检测方法

研究背景于意义

在开放世界中,构建稳健的机器学习模型需要应对数据的偏移,分布外检测(Out-of-Distribution Detection,OOD)因此成为不可或缺的技术之一。传统机器学习方法多基于封闭世界假设,即假设训练数据和测试数据来自同一分布。然而,在现实应用中,系统经常会遇到分布外的数据,这些数据并未在训练过程中出现。分布外检测技术已经逐步取得成果,在一定程度上提高了系统应对未知输入的能力[1]。但有研究表明,现有的分布外检测方法对对抗性输入的鲁棒性较差[2],这对于安全性产生了进一步的威胁。鲁棒分布外检测的目标是在对抗性攻击下,检测器能够依然准确地区分分布内和分布外数据,并做出正确的响应决策。鲁棒分布外检测有助于解决分布外检测方法在面对对抗性攻击时的脆弱性,增强检测器在面对对抗性输入时的可靠性和安全性。

本文工作

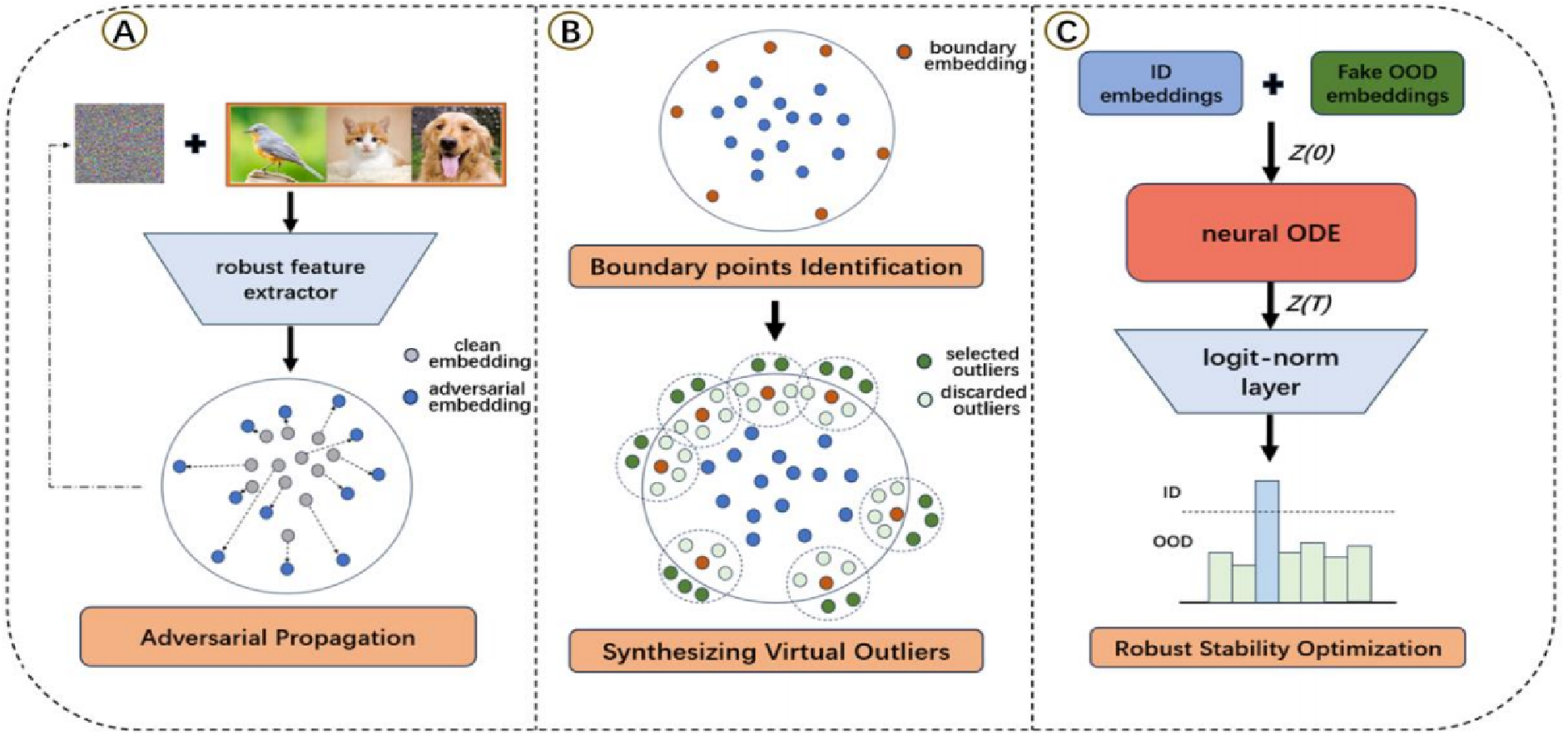

本文提出了一种基于对抗虚拟离群值生成的鲁棒分布外检测方法。模型主要由预训练鲁棒特征提取器、神经微分方程模块、logit归一化层和MSP阈值判断组成。预训练鲁棒特征提取器可以对对抗噪声进行初步去噪;神经微分方程模块通过将输出稳定到输入的平衡点附近进行进一步的对抗扰动去噪,以获得更强的鲁棒性;logit归一化层使模型只关注输出的方向,利于置信度校准,增强分布外检测能力;MSP阈值判断通过最大softmax值,设置阈值判断输入的类型。一些方法采用了离群值暴露[3]的策略,本文抛弃离群值暴露,具有更强的适用性。为了获得分布外信息,本文采用了一种基于采样的方法。整体方法框架如图1所示:

图1 方法框架图

鲁棒特征提取

鲁棒特征提取器采用对抗训练的策略进行预训练。对抗训练是已知有效的一种对抗防御方法,该方法通过内部最大化问题的求解获得对抗样本,通过外部最小化问题的求解优化网络参数。其数学表达形式如下,$\delta$为对抗扰动,$L$为分类损失:

\(\underset{\theta}{\min \quad E_{(x, y) \sim D^{\text {train }}} \max _{\delta \sim B(x, \epsilon)} L(f(x+\delta), y)\)

对抗虚拟离群值生成

在进行特征提取后,本文通过在特征空间的低似然区域采样获取虚拟离群值。具体来说,对于所有的输入,对其施加对抗攻击使其产生偏移,然后再获取所有输入边界区域的嵌入点。边界区域嵌入点的获取利用k近邻距离进行识别:

\[d_{kNN}(z^C,\mathbb{Z}_{in})=\left\|z^C-z_{(k)}^C\right\|_2\]获取所有输入的k近邻距离之后,设置一个阈值进行边界点区分,选取具有较大k近邻距离的点作为边界嵌入点。为了获得虚拟离群值,在边界嵌入点中心以一个高斯核进行采样:

\[v{\sim}\mathcal{N}(z,\sigma^2\boldsymbol{I})\]挑选远离输入嵌入区域的点作为虚拟离群值,将靠近输入嵌入区域的点进行抛弃。通过多步这样的操作即获得了一个虚拟离群值集合,将其作为分布外样本。

对抗扰动去噪

本文利用神经微分方程进行对抗扰动去噪,通过保证小扰动下神经微分方程解的收敛性来获得对抗鲁棒性保证,相关的方法在对抗鲁棒性领域已经充分研究,但未在分布外检测中得到充分使用。在神经微分方程中,输入输出可通过以下公式表示:

\(\frac{dz(t)}{dt}=f_{\theta}(z(t),t),z_{in}=z(0),z_{out}=z(T)\)

通过保证小扰动下神经微分方程解的收敛性,可以使得$z_{in}$趋近于$z_{out}$,即小扰动施加给输入后会被神经微分方程驱使到平衡点从而达到去噪的效果。

输出检测

本文采用logit归一化后的最大softmax分数作为检测是否是分布外的指标。logit归一化消除了logit大小的影响,使模型只关注输出的方向,有利于利于置信度的校准,对分布外检测任务有效。在经过softmax之后,模型便得到了输出的概率分布:

\[\sigma_i(z)=\frac{e^{z_i}}{\sum_{j=1}^ne^{z_j}}\]为了检测输出是否是分布外,采用最大softmax值作为指标,并设置阈值进行判断:

\[A_{ij}=\begin{cases}max \sigma_i(z)>\lambda,\ 分布内 \\ max \sigma_i(z)<\lambda,\ 分布外\end{cases}\]实验结果

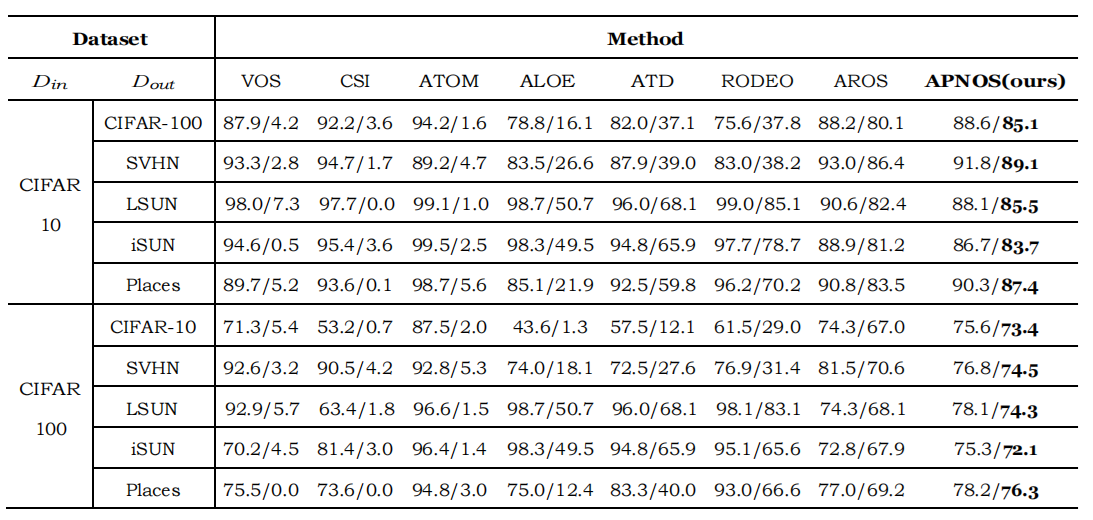

为了验证方法的有效性,本文以分布内数据集CIFAR-10和CIAFAR-100进行了多组对比实验,以SVHN、LSUN、iSUN、Places作为分布外样本。采用AUC曲线下积分面积作为衡量方法有效性的指标。对比的基线方法有VOS 、CSI、ATOM、ALOE、ATD、RODEO、AROS。实验结果如下,可以看出本文方法具有较强的优势。

表1 对比实验

参考文献

- [1]D. Hendrycks, M. Mazeika, and T. G. Dietterich, “Deep Anomaly Detection with Outlier Exposure,” International Conference on Learning Representations,International Conference on Learning Representations, Sep. 2018.

- [2]N. Carlini and D. Wagner, “Towards Evaluating the Robustness of Neural Networks,” in 2017 IEEE Symposium on Security and Privacy (SP), 2017.

- [3]J. Yang, K. Zhou, Y. Li, and Z. Liu, “Generalized Out-of-Distribution Detection: A Survey,” 0AD.